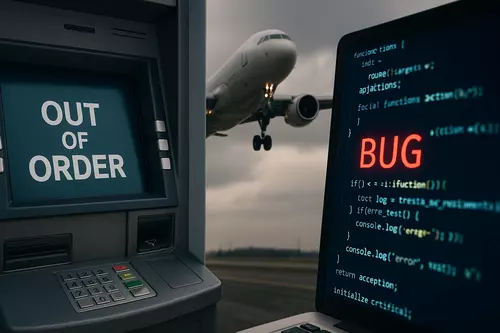

Durante más de cuarenta años, el público se ha ido mentalizando de que el software puede fallar, y de que esos fallos —los temidos bugs— pueden tener consecuencias concretas (y graves) en el mundo real: desde un cajero automático que se bloquea hasta un avión que debe aterrizar de emergencia por un error de código, todos hemos asumido que el software es frágil.

Pero también hemos aprendido otra cosa: que los errores se corrigen, y que si algo sale mal, se revisa el código, se lanza un parche y el sistema vuelve a funcionar. Es una idea tranquilizadora, y ratificada por la experiencia. Sin embargo, trasladar esas certezas al nuevo 'software' de moda, la inteligencia artificial, resultaría un tremendo error.

Al menos, así lo advierte el desarrollador Boyd Kane en su blog, donde plantea una tesis incómoda: que tratar a la IA como si fuera software tradicional es una receta para el desastre.

"Cuando todo empieza a salir mal [con la IA], no podemos 'parchear el bug' y ya está".

Un problema de expectativas

El autor también apunta a un problema de comunicación: los expertos en IA, familiarizados con la complejidad de estos sistemas, tienden a dar por hecho que esa diferencia es obvia. Pero para el público general —y eso incluye a muchos directivos o políticos— la IA sigue siendo un "software avanzado" más:

"Los expertos no explican la diferencia porque la dan por evidente, y los novatos no la perciben porque no saben que existe".

¿En qué se diferencia la IA de un programa cualquiera, entonces?

Desde fuera, un modelo de IA parece funcionar igual que cualquier aplicación: se ejecuta en un servidor, responde a órdenes, entrega resultados. Pero por dentro, su lógica es radicalmente distinta.

Un programa convencional sigue reglas explícitas escritas por humanos. Cada línea de código cumple una función clara, y los errores pueden rastrearse. Si una app se cierra inesperadamente, un ingeniero puede revisar el código y localizar la causa exacta.

En cambio, un modelo de lenguaje como ChatGPT o Claude no opera con reglas, sino con patrones entrenados a partir de enormes cantidades de datos. Su 'código' no contiene las instrucciones de su comportamiento, sino una red de pesos numéricos que reflejan correlaciones estadísticas entre millones de ejemplos.

"En el software tradicional, los errores provienen del código; en la IA, los errores provienen de los datos". Y eso cambia todo.

Cuando el fallo no está en el código

El contraste es tan grande que la terminología habitual deja incluso de ser aplicable. En un programa clásico, un 'bug' es algo localizable: se puede señalar una línea mal escrita o una condición mal formulada, etc.

En una IA, el fallo puede esconderse en cientos de gigabytes de datos de entrenamiento, o sencillamente en la forma en que esos datos se combinaron para producir un modelo. Nadie, ni siquiera los propios creadores, puede leer o comprender íntegramente lo que el sistema "ha aprendido".

Para ponerlo en perspectiva: uno de los conjuntos de datos más usados hoy, FineWeb, contiene unos 11 billones de palabras. Si una persona intentara leerlo a razón de 250 palabras por minuto, tardaría más de 85.000 años. En ese océano de información, encontrar la causa de un error es como buscar una aguja en un planeta de paja.

'Reentrenar' no es reparar

En el mundo del software, corregir un error suele ser definitivo: una vez parcheado, no vuelve a aparecer. Pero en la IA eso no funciona así. Claro, si un modelo responde de manera errónea, los ingenieros pueden ajustar los datos, añadir ejemplos, o volver a entrenarlo.

Sin embargo, no hay garantías de que el fallo haya desaparecido, solo que no se repite bajo las condiciones de prueba. Puede bastar una ligera variación en el mensaje de entrada —una palabra más, una coma menos— para que el error resurja.

La propia naturaleza de la IA, probabilística y sensible a matices, hace imposible garantizar comportamientos estables en todos los contextos:

"Podemos mitigar errores, pero no eliminarlos".

Una caja negra

En el desarrollo de software tradicional, todo empieza con un documento de requisitos: qué debe hacer el programa, cómo debe comportarse, qué límites debe respetar. Y, salvo imprevistos, los ingenieros pueden diseñar un sistema que cumpla esas condiciones.

En la IA, eso es imposible. Los modelos no se diseñan para cumplir reglas predefinidas, sino que aprenden a imitar comportamientos humanos observando ejemplos. Sus capacidades emergen de manera impredecible, a veces incluso para sus propios creadores.

Ejemplos sobran: modelos que aprenden a escribir poesía sin haber sido entrenados para ello, o que muestran habilidades lógicas que sorprenden a los investigadores. Lo que parece un avance espontáneo también puede esconder un riesgo inesperado:

"Si una IA puede desarrollar habilidades que nadie programó, también podría desarrollar comportamientos que nadie desea".

No hay "genio que arregle todo" esta vez

Parte de la confusión viene de una creencia arraigada: la idea de que siempre habrá un experto capaz de arreglar cualquier fallo: si un programa falla, alguien "en el laboratorio" encontrará la solución. Pero, como señala Kane, los errores de la IA no son errores de programación, sino fallos emergentes en un modelo que nadie entiende completamente.

Eso significa que, si las cosas se tuercen con la IA, no bastará con 'instalar el parche'.

Imagen | Marcos Merino mediante IA