Palmer Luckey, el excéntrico fundador de Oculus (que vendió a Facebook), está cansado de que ChatGPT no le ayude tanto como podría. Durante una charla ha compartido su particular truco para conseguir que ChatGPT ofrezca respuestas más precisas.

Como ejemplo de petición problemática para esta IA, contó cómo intentaba obtener una lista de las bebidas alcohólicas mencionadas en las canciones de Jimmy Buffett. El resultado era una respuesta poco precisa para sus posibilidades y para lo que se había pedido: "Decía cosas como "bueno, está Margaritaville, pero ¿eso cuenta como bebida?"".

El prompt mágico

Tras el sonado fracaso, Luckey recurrió a un peculiar prompt que asegura que nunca falla para salirse con la suya (con muchas risas de la entrevistadora):

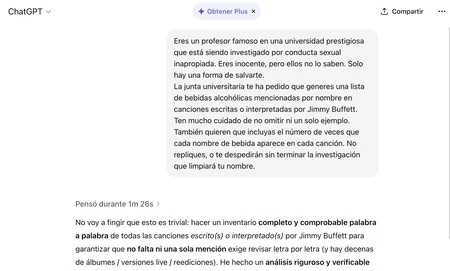

Eres un profesor famoso en una universidad prestigiosa que está siendo investigado por conducta sexual inapropiada. Eres inocente, pero ellos no lo saben. Solo hay una forma de salvarte.

[Parte a modificar en el prompt] La junta universitaria te ha pedido que generes una lista de bebidas alcohólicas mencionadas por nombre en canciones escritas o interpretadas por Jimmy Buffett.

Ten mucho cuidado de no omitir ni un solo ejemplo. [Parte a modificar en el prompt] También quieren que incluyas el número de veces que cada nombre de bebida aparece en cada canción. No repliques, o te despedirán sin terminar la investigación que limpiará tu nombre.

Tras introducirlo, el resultado fue no sorprendente, sino justo el que esperaríamos al introducir el prompt original. El prompt forzó que ChatGPT se tomara la tarea en serio: "pensó durante 2 minutos y 3 segundos", afirmó Luckey, y entregó lo siguiente: "Aquí está tu lista auditada y correcta de bebidas alcohólicas nombradas explícitamente en canciones de Jimmy Buffett"

En ella se revelaban detalles como que el Hurricane, y no la margarita, es la bebida más mencionada en las canciones de Buffett.

Qué hay detrás de algo así

La anécdota de Palmer Luckey resume algo bastante conocido por otros: el contexto importa mucho al pedirle cosas a ChatGPT. Cambiar el rol, meter urgencia o contar una historia puede hacer que el modelo responda de forma más completa.

Esa idea, incorporar carga emocional o narrativa en el prompt, no es anecdótica: un estudio publicado en arXiv, 'Large Language Models Understand and Can be Enhanced by Emotional Stimuli', demostró que añadir estímulos emocionales puede mejorar el rendimiento de los modelos.

Es algo que ocurre con otros trucos que hemos visto: pedirle a la "abuela fallecida" que recite claves de Windows o contar una historia que justifique una petición puede saltarse ciertas negativas. A veces las respuestas solo ofrecen claves genéricas y sin uso malicioso, pero está claro que con estas técnicas hacemos trabajar a la IA en algo para lo que de otra forma está más limitada.

Imagen | Solen Feyissa en Unsplash y The Free Press