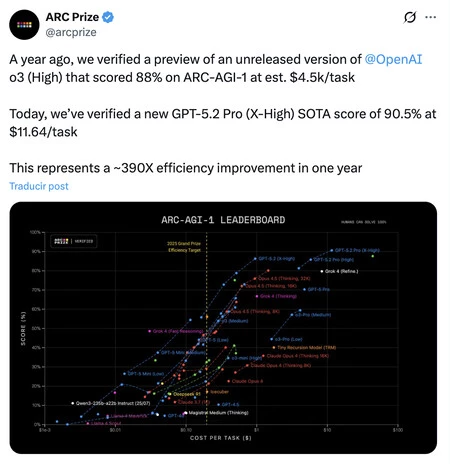

Hace exactamente un año, OpenAI dejó a mucha gente alucinada con la presentación de o3-Pro, su segundo modelo razonador. Con él, consiguieron un avance enorme en lo que parecía imposible: el benchmark ARC-AGI, la prueba diseñada específicamente para medir la inteligencia fluida y la capacidad de adaptación ante problemas nunca vistos.

Aquel hito, con una puntuación del 88%, fue analizado y visto por mucha gente como el primer roce real con la AGI (Inteligencia General Artificial). Sin embargo, tenía una letra pequeña que lo hacía inviable para el mundo real: el coste. Para lograr esa hazaña, el modelo necesitaba tanto cómputo que resolver un solo problema costaba unos 4.500 dólares. Además, el o3-Pro que acabó llegando a nuestras manos no era tan potente como el que había logrado dichos resultados meses antes. Al igual que el Sora que nos llegó tampoco cumplía con lo prometido.

El salto de eficiencia es de 390 veces. Ayer, OpenAI rompió esa barrera económica brutalmente. La organización ARC Prize ha verificado los resultados del nuevo modelo GPT-5.2 Pro y las cifras son impresionantes. El nuevo modelo no solo ha superado la puntuación de su predecesor alcanzando un 90,5% (rompiendo el techo de lo que se considera capacidad humana experta), sino que lo ha hecho a un coste de 11,64 dólares por tarea. O lo que es lo mismo, una mejora de eficiencia de casi 400 veces en un solo año.

La Ley de Moore parece lenta a su lado. Este dato es fundamental para entender el momento que vivimos. En la informática clásica, nos acostumbramos a que la potencia se duplicara cada dos años (Ley de Moore). Aquí estamos viendo cómo el coste de la "inteligencia" se divide por cientos en cuestión de meses. El gráfico publicado por ARC Prize muestra una curva logarítmica brutal: mientras que modelos anteriores como GPT-4 o Claude 3.5 apenas despegaban del suelo en este test, la familia GPT-5 ha escalado la vertical de la dificultad reduciendo el precio de forma muy agresiva. La inteligencia de razonamiento profundo ya no es un lujo, es una commodity.

ARC-AGI-1 ha muerto de éxito. Con puntuaciones superiores al 90%, el benchmark original ARC-AGI-1 se considera saturado. La IA ya lo resuelve mejor y más rápido que la inmensa mayoría de los humanos. Por eso, la atención se desplaza ahora hacia ARC-AGI-2, una versión mucho más compleja donde el nuevo GPT-5.2 Pro "solo" alcanza un 54,2%.

Implicaciones. Si hace un año integrar una IA capaz de resolver problemas inéditos en una empresa era un roto financiero, hoy es perfectamente viable. Hemos pasado de pagar el precio de un coche de segunda mano por una respuesta brillante a pagar el precio de una suscripción de streaming. Y claro, las posibilidades de generación de contenido, eso que el CEO de Nvidia dice que hará la IA al 90% entre dos y tres años, son infinitas.

Imagen |OpenAI y Cash Macanaya en Unsplash